2021.05.31 コラム

【API・データ検証奮闘記】#8.BigQuery Transfer Serviceやってみた

本コラムでは、APIやデータに関連する言語などを無邪気に触ってみた備忘録として、ライトに記載していきます!

「ちょっと違くない」「他にいい方法あるのに」といったご意見もあるかと思いますが、何卒お手柔らかに!!

<プロフィール>

富松 良介

2017年、株式会社サイバー・コミュニケーションズ(CCI)入社。Oracle Bluekai・Treasure Data等のDMPや、AWS・GCP等のPublicCloud領域を担務。2019年6月よりデータの利活用を推進するコンサルティング会社「株式会社DataCurrent」に出向し、事業会社の基盤構築・運用や自社ソリューション開発を担当。

●BigQuery Transfer Serviceやってみた

かしこまり!!

BigQuery Transfer Serviceを活用したS3からBigQueryへのデータ転送手順から格納した結果までをご紹介致します。

●ステップ1. どうやってS3とBigQueryを連携するか調査してみた

●ステップ2. BigQuery Transfer Serviceの準備

必要なものをそろえる

■S3の情報

・バケット名/パス

・ファイル名

・Access Key ID

・Secret Access Key

※AmazonS3 ReadOnlyAccess権限が必要

■GCPの権限、設定まわり

・BigQuery Transfer Service設定ユーザーへの権限設定

(bigquery.transfers.update、bigquery.transfers.get、bigquery.datasets.update)

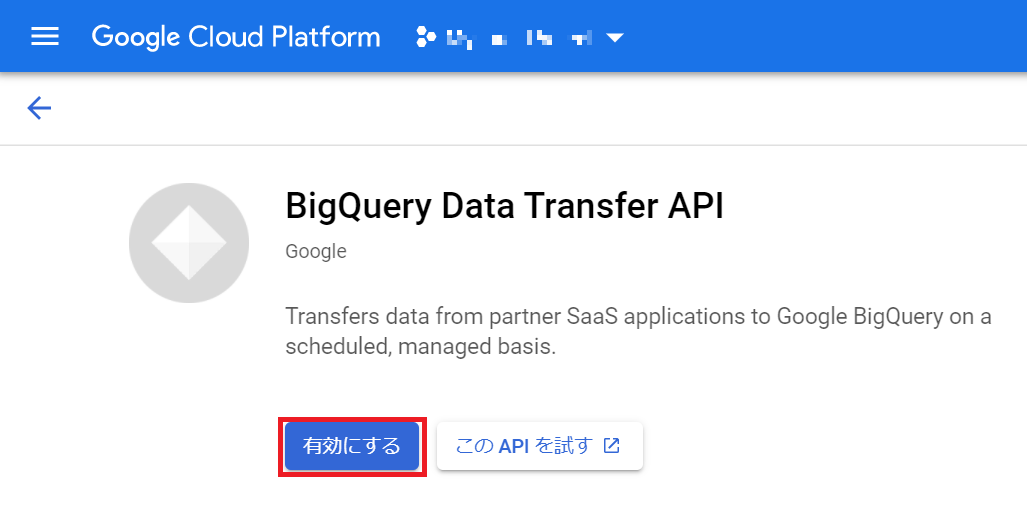

・BigQuery Data Transfer Service の有効化

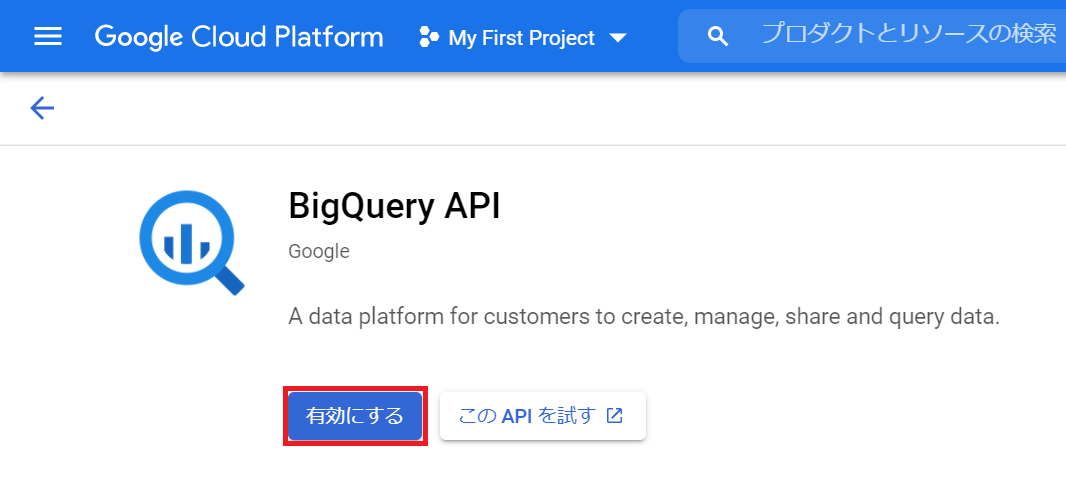

・BigQuery APIの有効化

●ステップ3. BigQuery Transfer Serviceの設定

データ転送設定してみる

「転送を作成」を押下

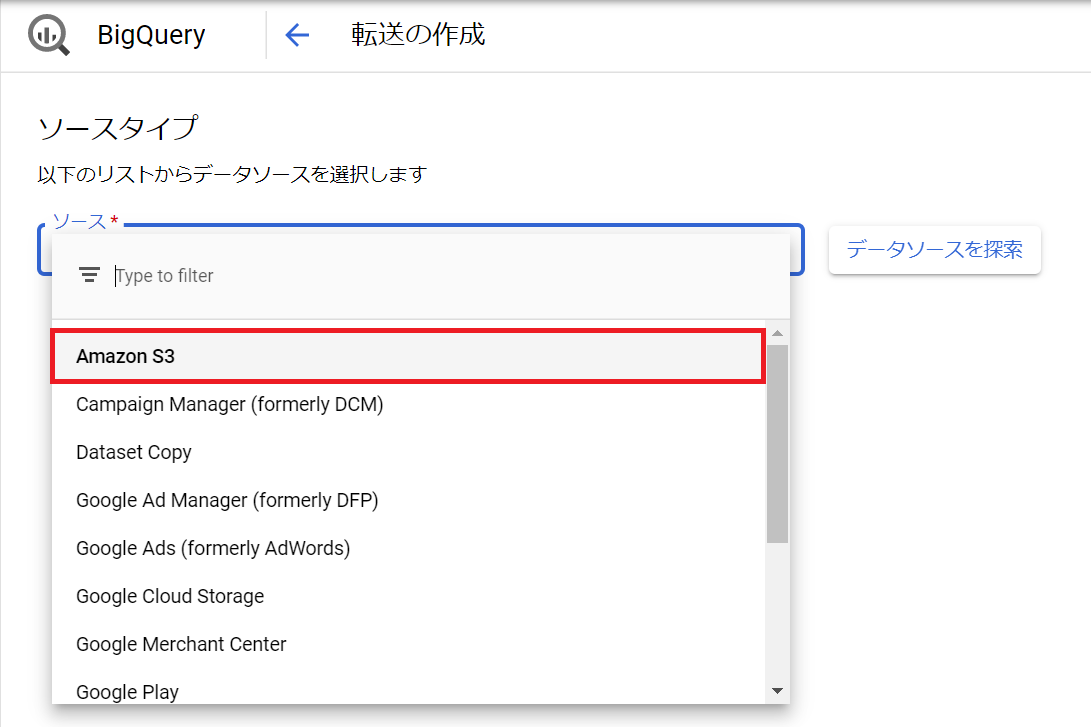

ソースタイプで「Amazon S3」を選択

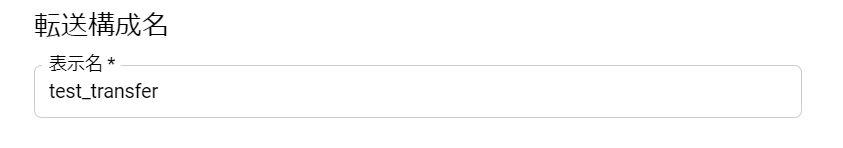

転送設定に任意の名前をつける

転送スケジュールを設定する

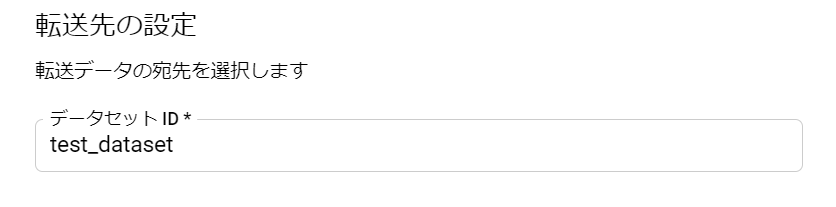

転送先BigQueryのデータセット名を選択する

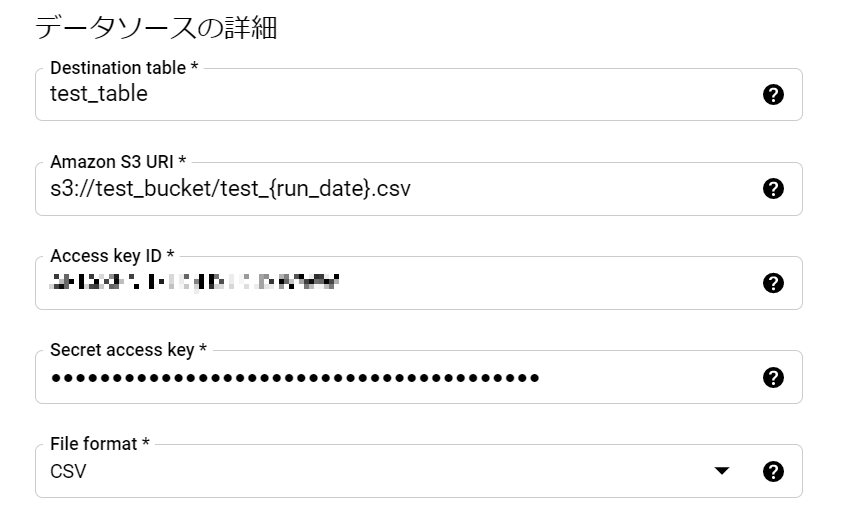

転送先BigQueryのテーブル名と、転送元データソースの情報を入力する

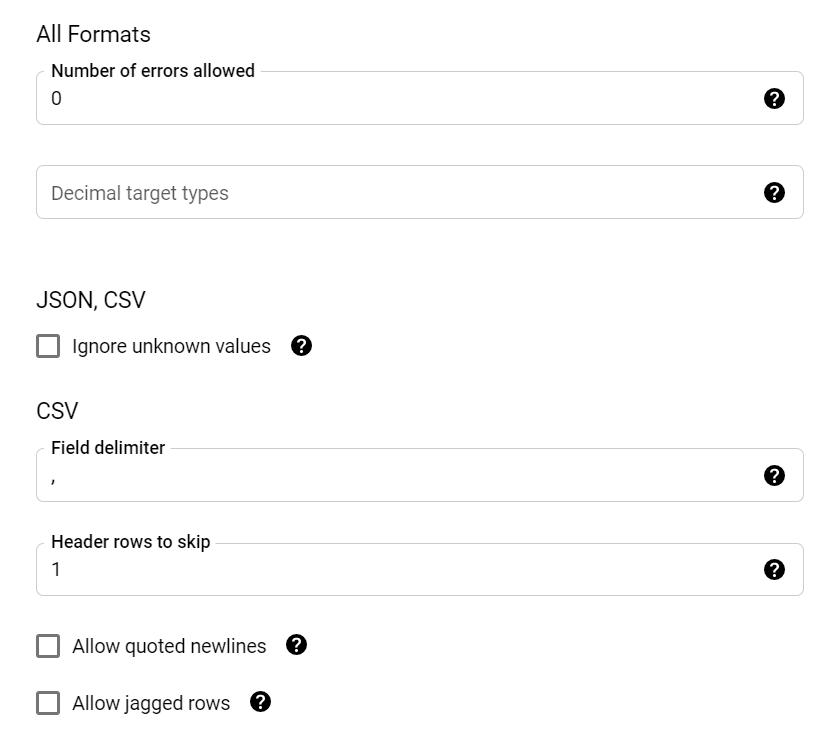

BigQueryデータ格納時のオプション設定をおこなう

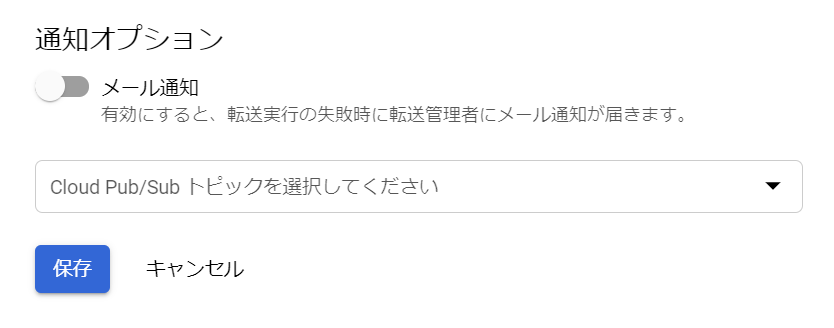

必要に応じてメール通知機能を設定する

設定完了!!!

●ステップ4. 転送結果

https://cloud.google.com/bigquery-transfer/docs/redshift-migration#grant_access_redshift_cluster/

●最後に

弊社では、ツール間のデータ連携や設定方法はもちろん、その他データの取り扱いに関する課題に対してトータルで支援しております。

お困りごとございましたら、お気軽にお問い合わせください。

本データに関するお問い合わせは下記にて承ります。

株式会社DataCurrent

info@datacurrent.co.jp